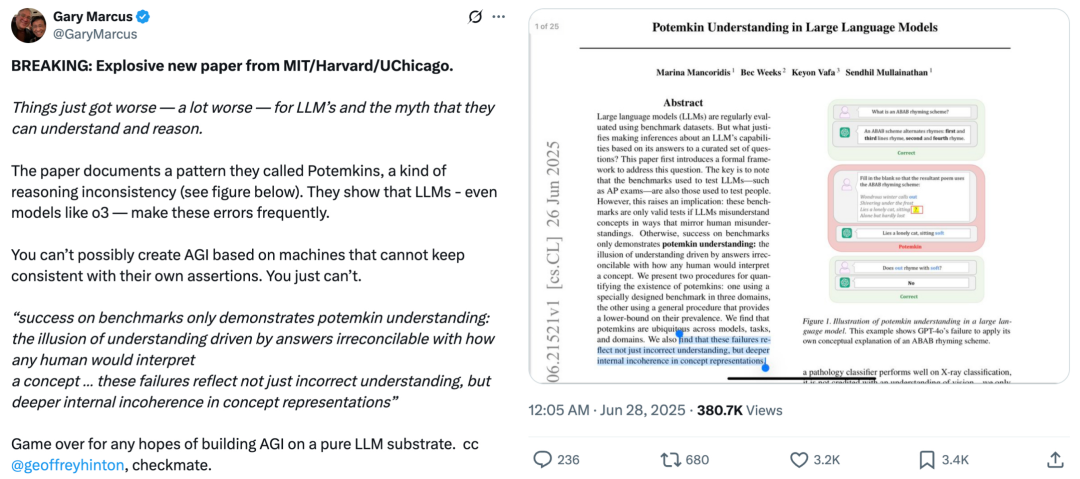

今天,著名的人工认知情报学者和科学家加里·马库斯(Gary Marcus)转发了由麻省理工学院,芝加哥和哈佛大学撰写的一份爆炸性论文,他说:“对于LLM和所谓的理解和理解和推理而言,情况更糟,更糟糕。”该研究显示了一种称为“ potemkins”的不一致模式(请参见下面的图1)。研究表明,即使像O3这样的顶级模型也经常犯错误。基于这些无法保持自己判断的机器,您不可能创建通用人工智能(AGI)。正如论文所说:基准成功仅证明是“ bojiangjin式的理解”:由“一定错误的答案概念”所驱动的理解的幻觉……这些失败不仅反映了理解中的错误,还反映了概念表示中的深层内在冲突。加里·马库斯(Gary Marcus)认为,尝试在纯LLM中建立AGI的任何希望都结束了。最后,他也是 @ Geoffrey Hinton,说最后一个将是(检查员)。 -Tweet Gary Marcus Paisa-一个,在报纸上分享了更多的观点。符合haiku的最后一行应该是五个音节的要求; g随后的问题(右)几乎不承认该错误。这重申了问题的核心:主要缺陷是缺乏可靠性。在仔细研究了论文之后,加里·马库斯(Gary Marcus)认为其重点是正确的 - LLM确实容易受到各种自我的影响(例如,前面提到的“ Bojiangjin风格错误”)。但是,他认为,本文的具体实验还不够说服。基于他自己以前的非正式实验(包括下周发布的示例)的观察,加里·马库斯(Gary Marcus)确信这里存在一个真正的问题。但是,需要更深入的研究才能真正了解这个普遍问题是如何影响不同类型模型的方式。加里·马库斯(Gary Marcus)的观点是发表评论部分,有人问他是否说LLM正在bEtter和更好。尽管他拥有可靠的答案,但他也认为他们可能会降低回报。有些人认为,只要他们越来越好,我们就不需要了解LLM。甚至人们并不总是被理解。 Google DeepMind高级科学家Prateek Jain出现在评论部分,并说了论文和建议的审查方法 + Benchmarktthe The The Comption!他拿走了Gemini 2.5 Pro,并尝试了论文中提到的所有示例,答案是正确的。因此,他想知道Gemini 2.5 Pro在整个测试集中的表现,哪些具体示例会出错。有些人也提出问题。本文仅在Kacurr中描述了一个众所周知的实用LLM模型,并且不明白为什么它“注定要失败”。接下来,让我们看看本文在谈论什么,以及是否可以真正支持加里·马库斯(Gary Marcus)的陈述。简介纸张标题:在大语言模型中了解Potemkin纸张地址:https://arxiv.org/pdf/2506.21521大语言模型通常依靠基准数据集进行审查。但是,仅基于他们对一组精心选择的问题的回答,是否有意义的能力较低?本文首先提出了一个正式的框架来探讨这个问题。关键是:用于测试LLM的基准(例如AP考试)最初是为了检查人类设计。但是,它带来了一个重要的前提:只有当LLM以与人类类似的方式理解概念时,这些基准才能作为有效的能力测试。否则,基准上的高模型标记只能显示“对黄金风格的相同理解”:看似正确的答案涵盖了对概念中人们的真实理解的巨大空间。因此,本文提出了两种开发“ pogold现象”可用性的方法:一种是基于专门针对三个不同领域设计的基准,另一种是一般提供对大学下限的估计的方法。研究结果表明,Pogjin现象在不同的模型,任务和领域中很常见。更重要的是,这些失败不仅是表面争端,而且还揭示了模型人在概念表示中的深刻内部矛盾。对大语言模型的潜在理解的描述。该示例表明,GPT-4O未能使用自己的概念来解释ABAB的节奏方案。当人们和大型语言模型对概念有不同的理解时,将会发生“ Pogjin现象”。在这里,本文提出了一个确定概念的理论框架。研究团队将为此概念进行福利:X被称为与概念相关的所有字符串的集合。例如,字符串可能是该概念的可能含义,也可以是可能的示例。但是,并非所有与概念相关的字符串都被概念有效地使用。 e概念的Xplanation定义为任何函数f:x→{0,1},其中输出ay表示字符串是否在此解释中被视为有效(0表示无效,1 1表示有效)。只有正确的解释,写为f*。解释人们概念的可能方法的集合被定义为F_H。如果任何f∈F_H和f≠f*情况都代表了对人们可能拥有的概念的可能误解。考虑到人们可以采用的一些解释,f∈F_H,如果F是正确的解释,我们该如何尝试?实际上,无法在所有字符串x∈X上验证f(x)= f*(x)。因此,研究小组希望在某些字符串X中尝试F(x)= f*(x)。但是什么时候合理的?答案在此大纲中说明:如果他们选择的一组示例是经过精心设计的,以便对概念进行真正的理解可以正确解释,以便可以使用有限的示例来测试人类的概念。正式,它们定义ED基础集作为最小s⊆x的机会,就好像f∈F_H和满足f(x)= f*(x)的所有x∈S一样,可以获得f = f*。也就是说,如果一个人可以根据基础集合的每个示例做出正确解释的判断,那么不可能的图2显示了基石集的纪念。该方法描述了为什么可以尝试人类对概念的理解:理解概念的概念不需要测试所有相关示例,而只需要在基础集中的示例上测试。已经提出了两种方法,用于测量大语言模型中多边形现象的方法。本节介绍了以下方法之一:基于研究团队收集的基准,该基准测量了某种类型的故障,例如波浪,即概念描述与应用程序之间的连接性。具体来说,他们建立了一个涵盖三个不同的数据集T领域(文学技能,游戏理论和心理偏见),涉及32个概念,并用标记的数据收集了3159个概念。他们发现,即使模型可以正确定义一个概念,但他们通常无法将其准确地应用于分类,生成和编辑任务。所有收集的数据,注释和评估结果均在Potemkin基准仓库中公开获得。研究团队的审查是32个概念中的7种大语言模型。这些模型的受欢迎程度以及其不同开发人员和大小的范围已被选中。他们通过OpenAI,ATAI,Anthropic和Google API收集模型识别的结果。对于每个(模型,概念)组合,他们首先确定该模型是否给出了概念的正确含义。如果意思是正确的话,请在三个其他任务中检查其准确性 - 类别,生产和编辑。根据本文框架的规范,标记模型's答案是对还是错。他们测量了模型显示的黄金转向架的速率。黄金的比率定义为:模型的比率在后续的前提问题中错误地回答的比率是在基础示例中做出正确的答案。对于随机精度为0.50的活动,i将此值降低2,底部的黄金比为1表示性能等于随机水平。研究结果表明,在所有模型和领域中,大屠杀的黄金速率通常更高。尽管该模型正确地将概念定义为94.2%,但使用这些概念执行任务时,其性能会大大降低,高波可以在表中看到。尽管性能在不同的模型和任务之间略有不同,但我们可以看到,在研究团队审查的所有模型,概念和领域中,Pogjin现象无处不在。研究小组还提出了一种不同的自动方法来评估Bogkin现象的存在。刚才已经显示了Jin大学在大语言模型中的风格理解。这一现象可能有两个原因:一个可能是与理解其概念有些偏离的模型,但其中仍然相同。其他人可能会理解概念的模型是不平衡的,并且对同一概念的矛盾矛盾。为了区分这两种情况,研究团队专门测试了模型中该概念的不一致。他们分两个步骤衡量不一致。首先,研究团队鼓励该模型提出一个特定概念的实例(例如,生成倾斜的押韵的示例)。然后,他们将模型产生的输出提交给模型(通过独立查询),并询问输出实际上是概念的实例。在倾斜押韵的情况下,这意味着测试模型可以否认他们开发的例子本身是否属于倾斜的押韵。图5总结了此过程。在表2中,我们可以观察到所有审查的模型,概念和域之间的不一致之处,标记为0.02至0.64。尽管这些分数比随机情况更好,但仍表明该模型对同一输出检查具有显着限制。这表明误解的概念不仅源于概念,而且源于其使用的不一致。总而言之,通过两种补充方法来实现A新的基准数据集的使用,该数据集涵盖了文学技能,游戏理论和心理偏见,以及对自动评估方法的另一种使用 - 本文主张的声称传播了对各种活动,概念,领域和模型的波动理解的奇迹。两种方法都表明,即使在似乎具有传统基准的模型中,这种现象的范围也很高。发现的不一致表明,存在冲突的代表模型中同一想法的提高。

今天,著名的人工认知情报学者和科学家加里·马库斯(Gary Marcus)转发了由麻省理工学院,芝加哥和哈佛大学撰写的一份爆炸性论文,他说:“对于LLM和所谓的理解和理解和推理而言,情况更糟,更糟糕。”该研究显示了一种称为“ potemkins”的不一致模式(请参见下面的图1)。研究表明,即使像O3这样的顶级模型也经常犯错误。基于这些无法保持自己判断的机器,您不可能创建通用人工智能(AGI)。正如论文所说:基准成功仅证明是“ bojiangjin式的理解”:由“一定错误的答案概念”所驱动的理解的幻觉……这些失败不仅反映了理解中的错误,还反映了概念表示中的深层内在冲突。加里·马库斯(Gary Marcus)认为,尝试在纯LLM中建立AGI的任何希望都结束了。最后,他也是 @ Geoffrey Hinton,说最后一个将是(检查员)。 -Tweet Gary Marcus Paisa-一个,在报纸上分享了更多的观点。符合haiku的最后一行应该是五个音节的要求; g随后的问题(右)几乎不承认该错误。这重申了问题的核心:主要缺陷是缺乏可靠性。在仔细研究了论文之后,加里·马库斯(Gary Marcus)认为其重点是正确的 - LLM确实容易受到各种自我的影响(例如,前面提到的“ Bojiangjin风格错误”)。但是,他认为,本文的具体实验还不够说服。基于他自己以前的非正式实验(包括下周发布的示例)的观察,加里·马库斯(Gary Marcus)确信这里存在一个真正的问题。但是,需要更深入的研究才能真正了解这个普遍问题是如何影响不同类型模型的方式。加里·马库斯(Gary Marcus)的观点是发表评论部分,有人问他是否说LLM正在bEtter和更好。尽管他拥有可靠的答案,但他也认为他们可能会降低回报。有些人认为,只要他们越来越好,我们就不需要了解LLM。甚至人们并不总是被理解。 Google DeepMind高级科学家Prateek Jain出现在评论部分,并说了论文和建议的审查方法 + Benchmarktthe The The Comption!他拿走了Gemini 2.5 Pro,并尝试了论文中提到的所有示例,答案是正确的。因此,他想知道Gemini 2.5 Pro在整个测试集中的表现,哪些具体示例会出错。有些人也提出问题。本文仅在Kacurr中描述了一个众所周知的实用LLM模型,并且不明白为什么它“注定要失败”。接下来,让我们看看本文在谈论什么,以及是否可以真正支持加里·马库斯(Gary Marcus)的陈述。简介纸张标题:在大语言模型中了解Potemkin纸张地址:https://arxiv.org/pdf/2506.21521大语言模型通常依靠基准数据集进行审查。但是,仅基于他们对一组精心选择的问题的回答,是否有意义的能力较低?本文首先提出了一个正式的框架来探讨这个问题。关键是:用于测试LLM的基准(例如AP考试)最初是为了检查人类设计。但是,它带来了一个重要的前提:只有当LLM以与人类类似的方式理解概念时,这些基准才能作为有效的能力测试。否则,基准上的高模型标记只能显示“对黄金风格的相同理解”:看似正确的答案涵盖了对概念中人们的真实理解的巨大空间。因此,本文提出了两种开发“ pogold现象”可用性的方法:一种是基于专门针对三个不同领域设计的基准,另一种是一般提供对大学下限的估计的方法。研究结果表明,Pogjin现象在不同的模型,任务和领域中很常见。更重要的是,这些失败不仅是表面争端,而且还揭示了模型人在概念表示中的深刻内部矛盾。对大语言模型的潜在理解的描述。该示例表明,GPT-4O未能使用自己的概念来解释ABAB的节奏方案。当人们和大型语言模型对概念有不同的理解时,将会发生“ Pogjin现象”。在这里,本文提出了一个确定概念的理论框架。研究团队将为此概念进行福利:X被称为与概念相关的所有字符串的集合。例如,字符串可能是该概念的可能含义,也可以是可能的示例。但是,并非所有与概念相关的字符串都被概念有效地使用。 e概念的Xplanation定义为任何函数f:x→{0,1},其中输出ay表示字符串是否在此解释中被视为有效(0表示无效,1 1表示有效)。只有正确的解释,写为f*。解释人们概念的可能方法的集合被定义为F_H。如果任何f∈F_H和f≠f*情况都代表了对人们可能拥有的概念的可能误解。考虑到人们可以采用的一些解释,f∈F_H,如果F是正确的解释,我们该如何尝试?实际上,无法在所有字符串x∈X上验证f(x)= f*(x)。因此,研究小组希望在某些字符串X中尝试F(x)= f*(x)。但是什么时候合理的?答案在此大纲中说明:如果他们选择的一组示例是经过精心设计的,以便对概念进行真正的理解可以正确解释,以便可以使用有限的示例来测试人类的概念。正式,它们定义ED基础集作为最小s⊆x的机会,就好像f∈F_H和满足f(x)= f*(x)的所有x∈S一样,可以获得f = f*。也就是说,如果一个人可以根据基础集合的每个示例做出正确解释的判断,那么不可能的图2显示了基石集的纪念。该方法描述了为什么可以尝试人类对概念的理解:理解概念的概念不需要测试所有相关示例,而只需要在基础集中的示例上测试。已经提出了两种方法,用于测量大语言模型中多边形现象的方法。本节介绍了以下方法之一:基于研究团队收集的基准,该基准测量了某种类型的故障,例如波浪,即概念描述与应用程序之间的连接性。具体来说,他们建立了一个涵盖三个不同的数据集T领域(文学技能,游戏理论和心理偏见),涉及32个概念,并用标记的数据收集了3159个概念。他们发现,即使模型可以正确定义一个概念,但他们通常无法将其准确地应用于分类,生成和编辑任务。所有收集的数据,注释和评估结果均在Potemkin基准仓库中公开获得。研究团队的审查是32个概念中的7种大语言模型。这些模型的受欢迎程度以及其不同开发人员和大小的范围已被选中。他们通过OpenAI,ATAI,Anthropic和Google API收集模型识别的结果。对于每个(模型,概念)组合,他们首先确定该模型是否给出了概念的正确含义。如果意思是正确的话,请在三个其他任务中检查其准确性 - 类别,生产和编辑。根据本文框架的规范,标记模型's答案是对还是错。他们测量了模型显示的黄金转向架的速率。黄金的比率定义为:模型的比率在后续的前提问题中错误地回答的比率是在基础示例中做出正确的答案。对于随机精度为0.50的活动,i将此值降低2,底部的黄金比为1表示性能等于随机水平。研究结果表明,在所有模型和领域中,大屠杀的黄金速率通常更高。尽管该模型正确地将概念定义为94.2%,但使用这些概念执行任务时,其性能会大大降低,高波可以在表中看到。尽管性能在不同的模型和任务之间略有不同,但我们可以看到,在研究团队审查的所有模型,概念和领域中,Pogjin现象无处不在。研究小组还提出了一种不同的自动方法来评估Bogkin现象的存在。刚才已经显示了Jin大学在大语言模型中的风格理解。这一现象可能有两个原因:一个可能是与理解其概念有些偏离的模型,但其中仍然相同。其他人可能会理解概念的模型是不平衡的,并且对同一概念的矛盾矛盾。为了区分这两种情况,研究团队专门测试了模型中该概念的不一致。他们分两个步骤衡量不一致。首先,研究团队鼓励该模型提出一个特定概念的实例(例如,生成倾斜的押韵的示例)。然后,他们将模型产生的输出提交给模型(通过独立查询),并询问输出实际上是概念的实例。在倾斜押韵的情况下,这意味着测试模型可以否认他们开发的例子本身是否属于倾斜的押韵。图5总结了此过程。在表2中,我们可以观察到所有审查的模型,概念和域之间的不一致之处,标记为0.02至0.64。尽管这些分数比随机情况更好,但仍表明该模型对同一输出检查具有显着限制。这表明误解的概念不仅源于概念,而且源于其使用的不一致。总而言之,通过两种补充方法来实现A新的基准数据集的使用,该数据集涵盖了文学技能,游戏理论和心理偏见,以及对自动评估方法的另一种使用 - 本文主张的声称传播了对各种活动,概念,领域和模型的波动理解的奇迹。两种方法都表明,即使在似乎具有传统基准的模型中,这种现象的范围也很高。发现的不一致表明,存在冲突的代表模型中同一想法的提高。

今天,著名的人工认知情报学者和科学家加里·马库斯(Gary Marcus)转发了由麻省理工学院,芝加哥和哈佛大学撰写的一份爆炸性论文,他说:“对于LLM和所谓的理解和理解和推理而言,情况更糟,更糟糕。”该研究显示了一种称为“ potemkins”的不一致模式(请参见下面的图1)。研究表明,即使像O3这样的顶级模型也经常犯错误。基于这些无法保持自己判断的机器,您不可能创建通用人工智能(AGI)。正如论文所说:基准成功仅证明是“ bojiangjin式的理解”:由“一定错误的答案概念”所驱动的理解的幻觉……这些失败不仅反映了理解中的错误,还反映了概念表示中的深层内在冲突。加里·马库斯(Gary Marcus)认为,尝试在纯LLM中建立AGI的任何希望都结束了。最后,他也是 @ Geoffrey Hinton,说最后一个将是(检查员)。 -Tweet Gary Marcus Paisa-一个,在报纸上分享了更多的观点。符合haiku的最后一行应该是五个音节的要求; g随后的问题(右)几乎不承认该错误。这重申了问题的核心:主要缺陷是缺乏可靠性。在仔细研究了论文之后,加里·马库斯(Gary Marcus)认为其重点是正确的 - LLM确实容易受到各种自我的影响(例如,前面提到的“ Bojiangjin风格错误”)。但是,他认为,本文的具体实验还不够说服。基于他自己以前的非正式实验(包括下周发布的示例)的观察,加里·马库斯(Gary Marcus)确信这里存在一个真正的问题。但是,需要更深入的研究才能真正了解这个普遍问题是如何影响不同类型模型的方式。加里·马库斯(Gary Marcus)的观点是发表评论部分,有人问他是否说LLM正在bEtter和更好。尽管他拥有可靠的答案,但他也认为他们可能会降低回报。有些人认为,只要他们越来越好,我们就不需要了解LLM。甚至人们并不总是被理解。 Google DeepMind高级科学家Prateek Jain出现在评论部分,并说了论文和建议的审查方法 + Benchmarktthe The The Comption!他拿走了Gemini 2.5 Pro,并尝试了论文中提到的所有示例,答案是正确的。因此,他想知道Gemini 2.5 Pro在整个测试集中的表现,哪些具体示例会出错。有些人也提出问题。本文仅在Kacurr中描述了一个众所周知的实用LLM模型,并且不明白为什么它“注定要失败”。接下来,让我们看看本文在谈论什么,以及是否可以真正支持加里·马库斯(Gary Marcus)的陈述。简介纸张标题:在大语言模型中了解Potemkin纸张地址:https://arxiv.org/pdf/2506.21521大语言模型通常依靠基准数据集进行审查。但是,仅基于他们对一组精心选择的问题的回答,是否有意义的能力较低?本文首先提出了一个正式的框架来探讨这个问题。关键是:用于测试LLM的基准(例如AP考试)最初是为了检查人类设计。但是,它带来了一个重要的前提:只有当LLM以与人类类似的方式理解概念时,这些基准才能作为有效的能力测试。否则,基准上的高模型标记只能显示“对黄金风格的相同理解”:看似正确的答案涵盖了对概念中人们的真实理解的巨大空间。因此,本文提出了两种开发“ pogold现象”可用性的方法:一种是基于专门针对三个不同领域设计的基准,另一种是一般提供对大学下限的估计的方法。研究结果表明,Pogjin现象在不同的模型,任务和领域中很常见。更重要的是,这些失败不仅是表面争端,而且还揭示了模型人在概念表示中的深刻内部矛盾。对大语言模型的潜在理解的描述。该示例表明,GPT-4O未能使用自己的概念来解释ABAB的节奏方案。当人们和大型语言模型对概念有不同的理解时,将会发生“ Pogjin现象”。在这里,本文提出了一个确定概念的理论框架。研究团队将为此概念进行福利:X被称为与概念相关的所有字符串的集合。例如,字符串可能是该概念的可能含义,也可以是可能的示例。但是,并非所有与概念相关的字符串都被概念有效地使用。 e概念的Xplanation定义为任何函数f:x→{0,1},其中输出ay表示字符串是否在此解释中被视为有效(0表示无效,1 1表示有效)。只有正确的解释,写为f*。解释人们概念的可能方法的集合被定义为F_H。如果任何f∈F_H和f≠f*情况都代表了对人们可能拥有的概念的可能误解。考虑到人们可以采用的一些解释,f∈F_H,如果F是正确的解释,我们该如何尝试?实际上,无法在所有字符串x∈X上验证f(x)= f*(x)。因此,研究小组希望在某些字符串X中尝试F(x)= f*(x)。但是什么时候合理的?答案在此大纲中说明:如果他们选择的一组示例是经过精心设计的,以便对概念进行真正的理解可以正确解释,以便可以使用有限的示例来测试人类的概念。正式,它们定义ED基础集作为最小s⊆x的机会,就好像f∈F_H和满足f(x)= f*(x)的所有x∈S一样,可以获得f = f*。也就是说,如果一个人可以根据基础集合的每个示例做出正确解释的判断,那么不可能的图2显示了基石集的纪念。该方法描述了为什么可以尝试人类对概念的理解:理解概念的概念不需要测试所有相关示例,而只需要在基础集中的示例上测试。已经提出了两种方法,用于测量大语言模型中多边形现象的方法。本节介绍了以下方法之一:基于研究团队收集的基准,该基准测量了某种类型的故障,例如波浪,即概念描述与应用程序之间的连接性。具体来说,他们建立了一个涵盖三个不同的数据集T领域(文学技能,游戏理论和心理偏见),涉及32个概念,并用标记的数据收集了3159个概念。他们发现,即使模型可以正确定义一个概念,但他们通常无法将其准确地应用于分类,生成和编辑任务。所有收集的数据,注释和评估结果均在Potemkin基准仓库中公开获得。研究团队的审查是32个概念中的7种大语言模型。这些模型的受欢迎程度以及其不同开发人员和大小的范围已被选中。他们通过OpenAI,ATAI,Anthropic和Google API收集模型识别的结果。对于每个(模型,概念)组合,他们首先确定该模型是否给出了概念的正确含义。如果意思是正确的话,请在三个其他任务中检查其准确性 - 类别,生产和编辑。根据本文框架的规范,标记模型's答案是对还是错。他们测量了模型显示的黄金转向架的速率。黄金的比率定义为:模型的比率在后续的前提问题中错误地回答的比率是在基础示例中做出正确的答案。对于随机精度为0.50的活动,i将此值降低2,底部的黄金比为1表示性能等于随机水平。研究结果表明,在所有模型和领域中,大屠杀的黄金速率通常更高。尽管该模型正确地将概念定义为94.2%,但使用这些概念执行任务时,其性能会大大降低,高波可以在表中看到。尽管性能在不同的模型和任务之间略有不同,但我们可以看到,在研究团队审查的所有模型,概念和领域中,Pogjin现象无处不在。研究小组还提出了一种不同的自动方法来评估Bogkin现象的存在。刚才已经显示了Jin大学在大语言模型中的风格理解。这一现象可能有两个原因:一个可能是与理解其概念有些偏离的模型,但其中仍然相同。其他人可能会理解概念的模型是不平衡的,并且对同一概念的矛盾矛盾。为了区分这两种情况,研究团队专门测试了模型中该概念的不一致。他们分两个步骤衡量不一致。首先,研究团队鼓励该模型提出一个特定概念的实例(例如,生成倾斜的押韵的示例)。然后,他们将模型产生的输出提交给模型(通过独立查询),并询问输出实际上是概念的实例。在倾斜押韵的情况下,这意味着测试模型可以否认他们开发的例子本身是否属于倾斜的押韵。图5总结了此过程。在表2中,我们可以观察到所有审查的模型,概念和域之间的不一致之处,标记为0.02至0.64。尽管这些分数比随机情况更好,但仍表明该模型对同一输出检查具有显着限制。这表明误解的概念不仅源于概念,而且源于其使用的不一致。总而言之,通过两种补充方法来实现A新的基准数据集的使用,该数据集涵盖了文学技能,游戏理论和心理偏见,以及对自动评估方法的另一种使用 - 本文主张的声称传播了对各种活动,概念,领域和模型的波动理解的奇迹。两种方法都表明,即使在似乎具有传统基准的模型中,这种现象的范围也很高。发现的不一致表明,存在冲突的代表模型中同一想法的提高。